UntiyでHoloLensアプリを開発する場合、カメラ位置の変更や各機能の追加など、アプリ開発に入る前に結構やることがあります。

Academyに入っているPrefabを使ってもよいのですが「HoloToolkit-Unity」というツールキットがかなりよいので紹介します。

github.com

使い方

上記リポジトリはcloneなりダウンロードなりで手元に持ってきます。

Unityで新しいプロジェクトを作成します。

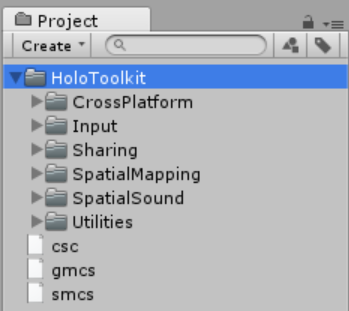

「HoloToolkit-Unity\Assets」にあるものすべてをProjectビューにコピーします(ここではGitHubからZIPでダウンロードしたのでmasterがついています)。拡張子がrspとmetaのものも入れてください。これらがない場合、コンパイルエラーになります。

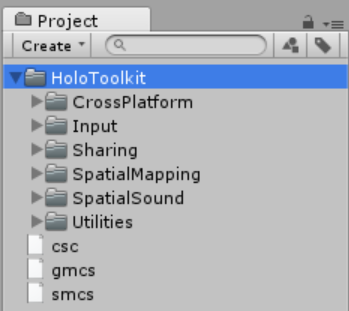

HoloToolkitフォルダ以下に機能ごとのフォルダがあります。

- CrossPlatform:内部で使用するクラスに関するもの

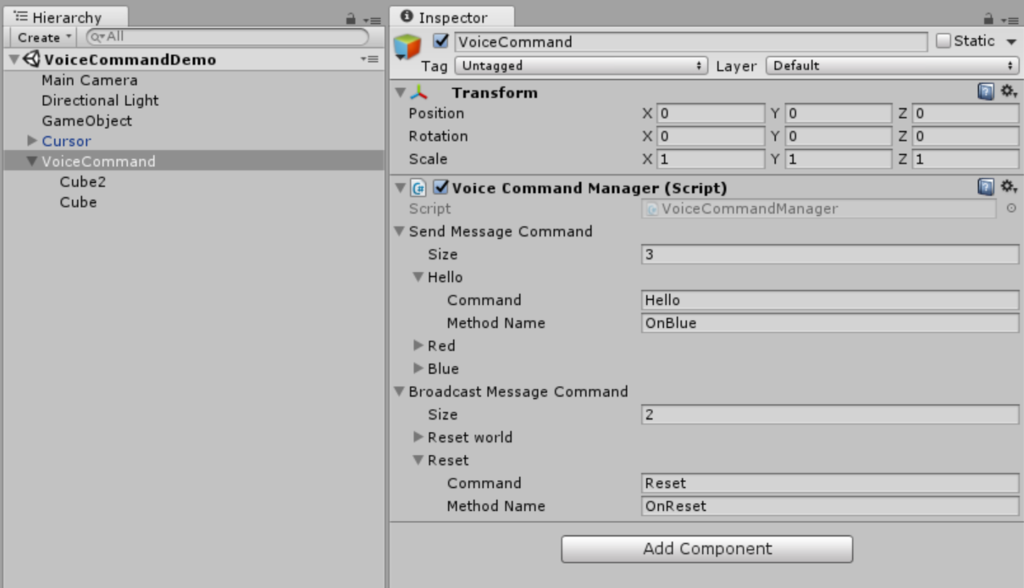

- Input:視線、ジェスチャー、音声コマンドといった入力に関するもの

- Sharing:共有に関するもの

- SpatialMapping:空間マッピングに関するもの

- SpatialSound:空間音響に関するもの

- Utilities:カメラなどのユーティリティ

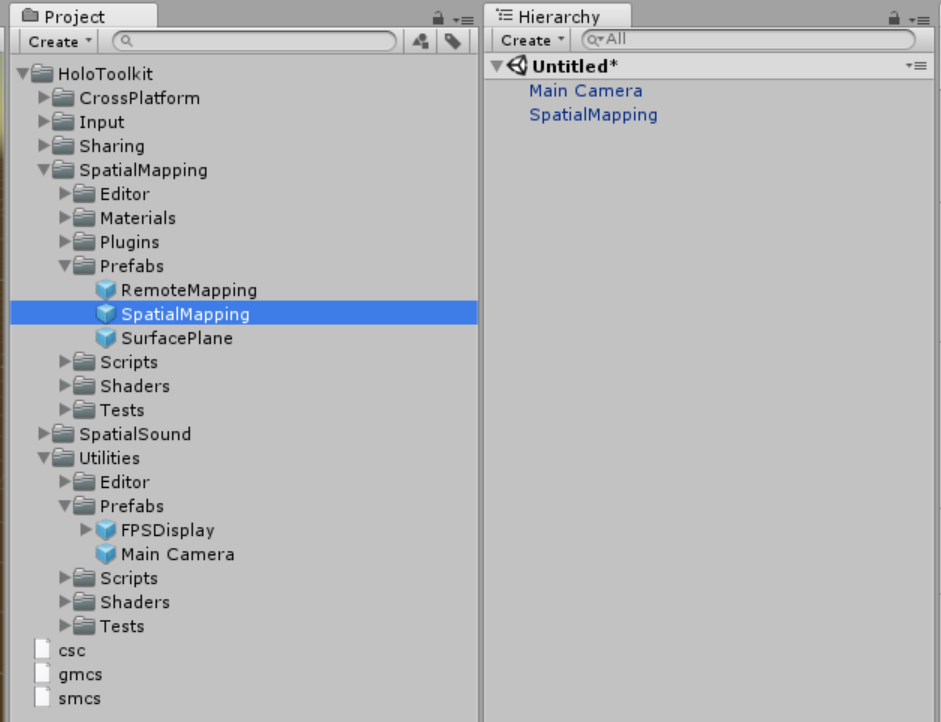

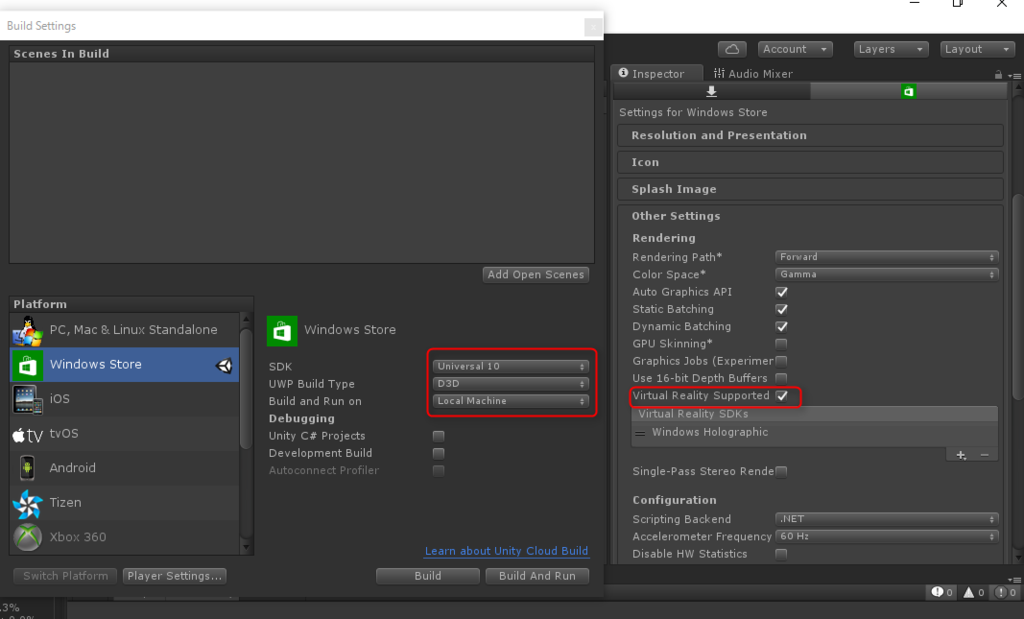

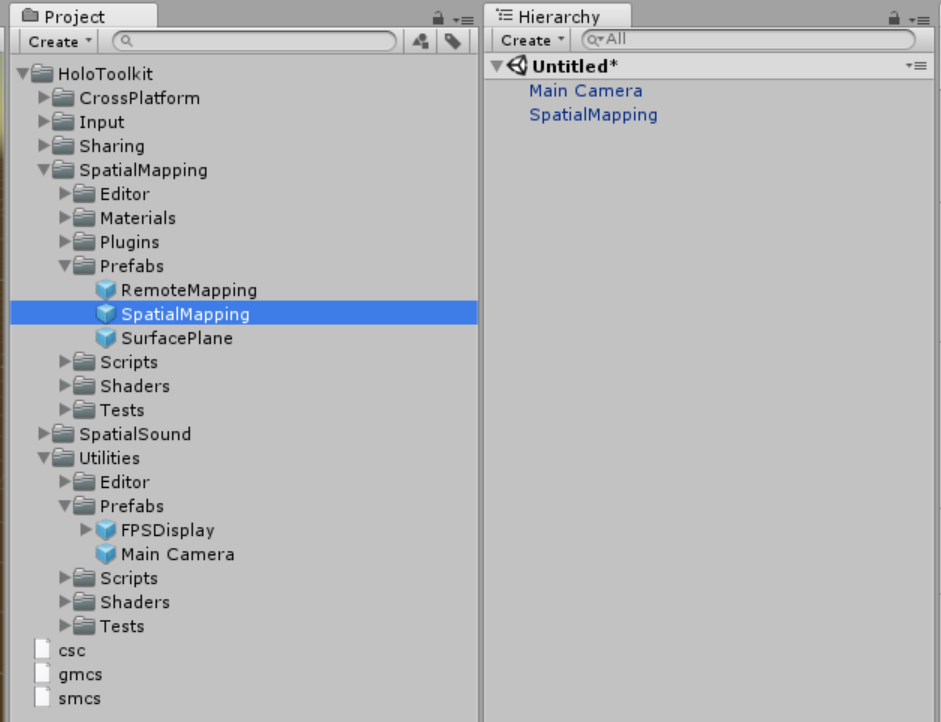

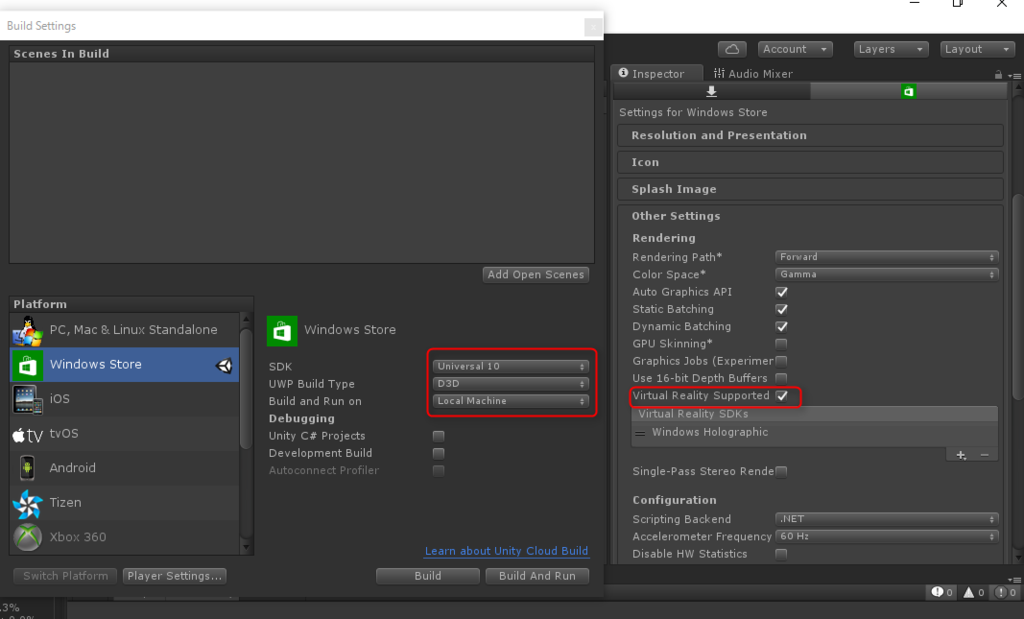

例えば、Hierarchyのものをすべて削除して、UtilityにあるMain Camera PrefabとSptialMappingにあるSptialMapping Prefabを配置します。Build SettingsからVR SupportとSptial Mappingの設定をすれば、空間マッピングをワイヤーフレームで表示してくれるアプリができあがります。

ほかにもジェスチャーもPrefabを配置するだけで、その機能を使えるようになります。

HoloLensアプリで共通で必要な機能についてはおおよそ網羅されているので、かなり便利に使えます。

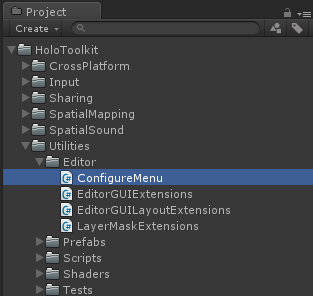

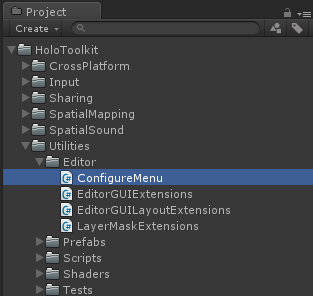

プロジェクト設定

Utilities\Editorの下にプロジェクト設定に関するスクリプトがあります。

HoloToolkit-Unityを追加すると、Unityのメニューに「HoloToolkit」が追加されます。

この中ではScene Settings(シーン設定:カメラの設定)、Project Settings(プロジェクト設定:VRモードやクオリティ設定、UWP出力の設定)、共有サーバーの起動などがあります。

Scene Settingsを実行するとカメラ設定がHoloLens用に変更されます。

Project Settingsでは、出力設定やVRモードのチェックなどを行ってくれます。

シーンの追加やCapabilityの設定は別途必要ですが、最初の忘れやすい設定を自動で行ってくれるので、非常に助かります。

動画とってみました

Introduction to HoloLens developed in Unity

![IO 2016年 07 月号 [雑誌] IO 2016年 07 月号 [雑誌]](http://ecx.images-amazon.com/images/I/61q0clA-UQL._SL160_.jpg)